作者:杨雨虹 历史版本:1 最后编辑:杨雨虹 更新时间:2025-11-12 16:08

概述

LLM节点主要是调用大语言模型,处理用户在前面节点中输入的信息,例如文字、图片等,并给出有效的回复。

节点配置

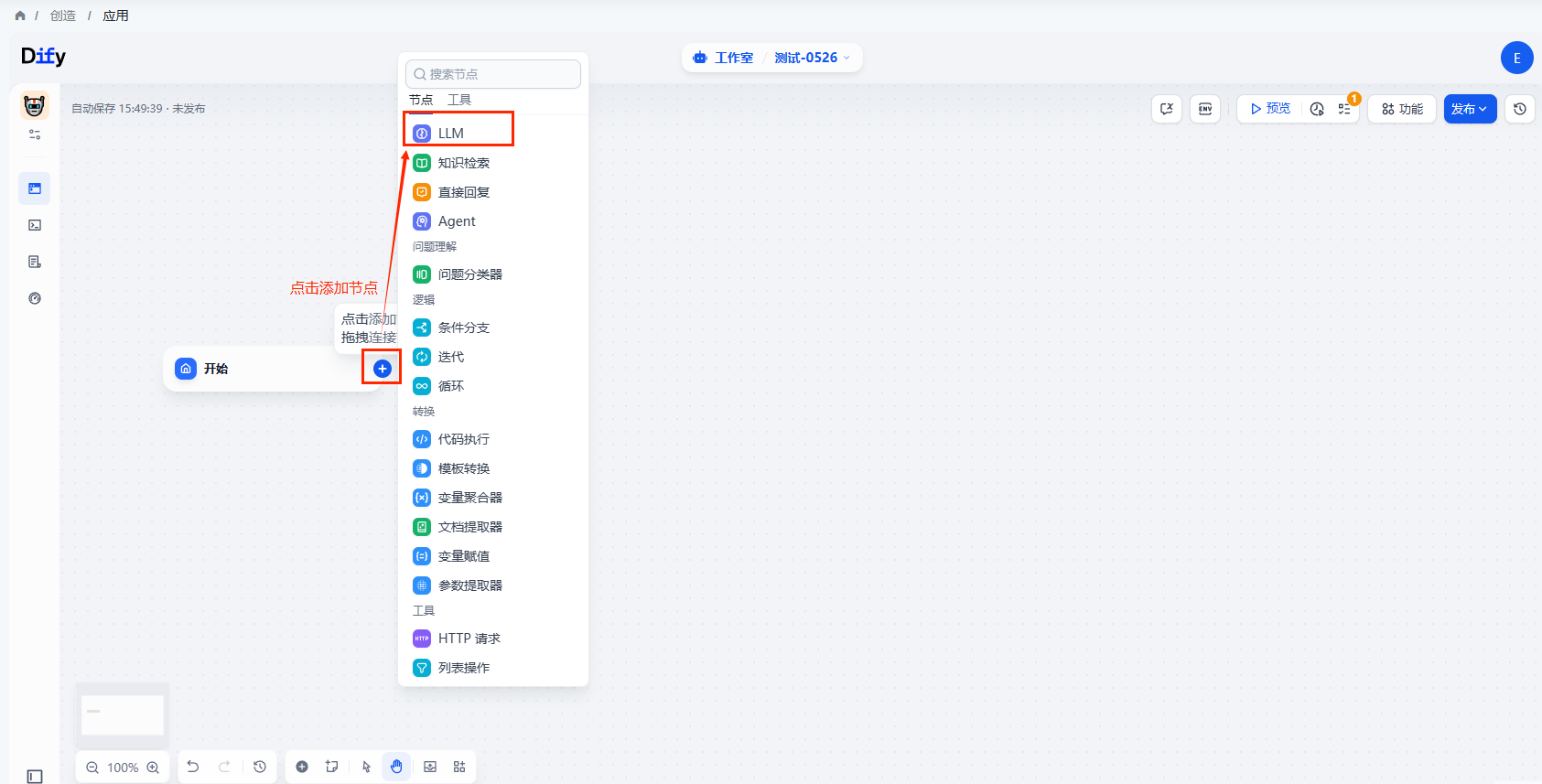

点击上一节点的+按钮,添加LLM节点

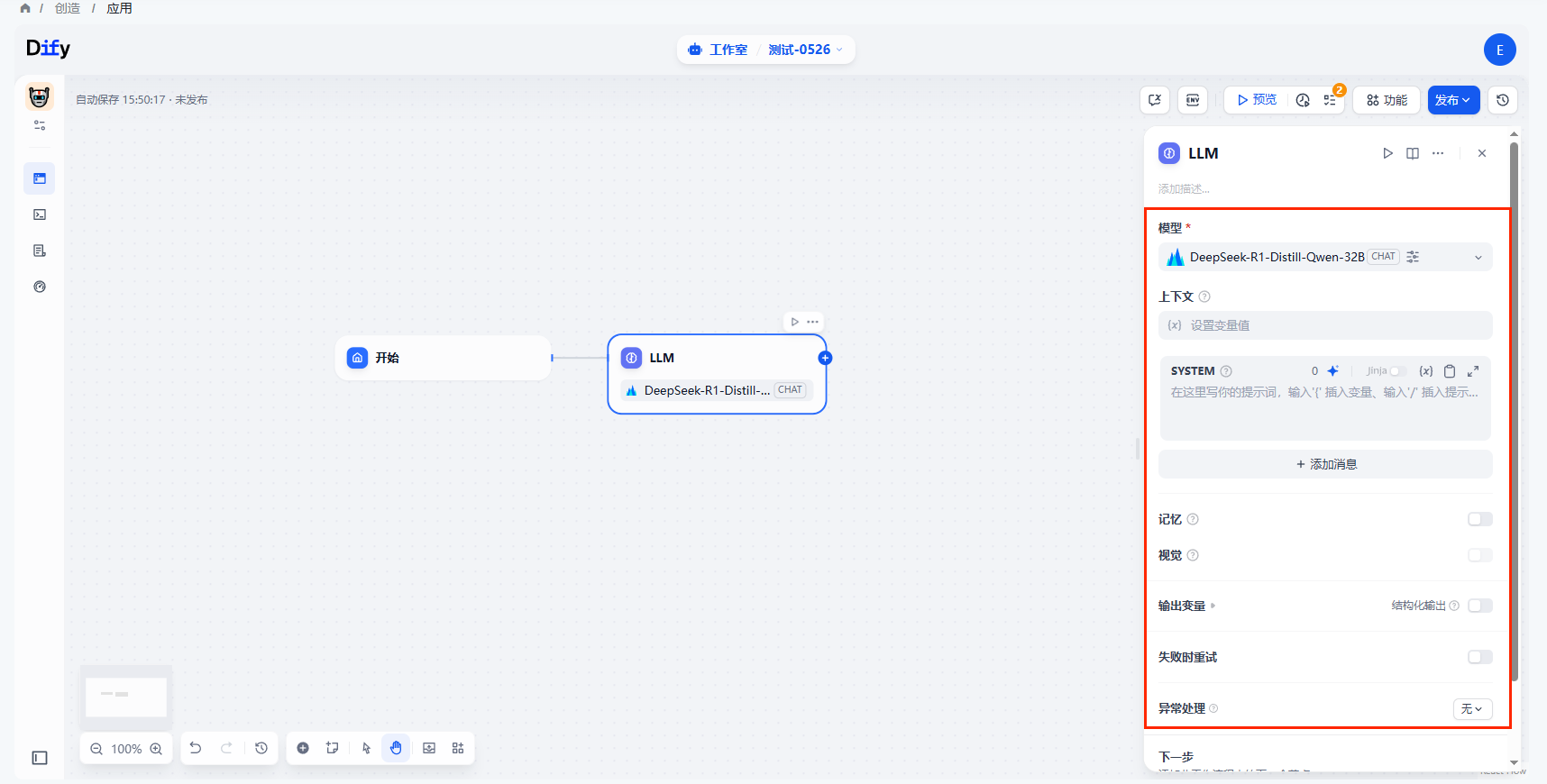

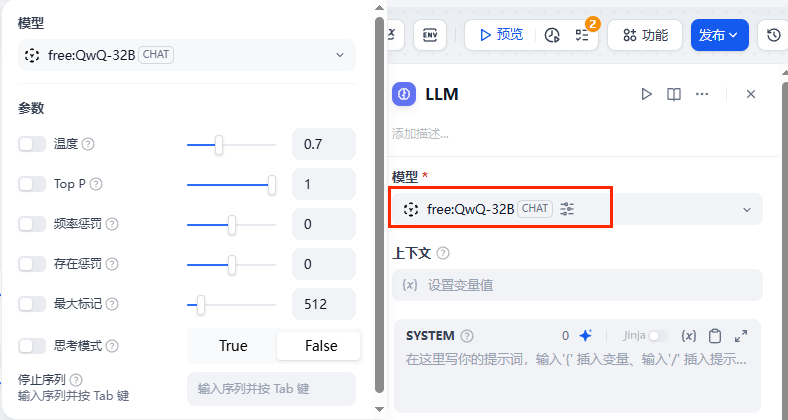

模型

根据业务类型和场景,选择合适的大语言模型。切换模型可配置不同的模型参数,例如温度、TopP,最大标记、回复格式等。

主要模型参数:

- 温度: 通常是0-1的一个值,控制随机性。温度越接近0,结果越确定和重复,温度越接近1,结果越随机。

- Top P: 控制结果的多样性。模型根据概率从候选词中选择,确保累积概率不超过预设的阈值P。

- 存在惩罚: 用于减少重复生成同一实体或信息,通过对已经生成的内容施加惩罚,使模型倾向于生成新的或不同的内容。参数值增加时,对于已经生成过的内容,模型在后续生成中被施加更大的惩罚,生成重复内容的可能性越低。

- 频率惩罚: 对过于频繁出现的词或短语施加惩罚,通过降低这些词的生成概率。随着参数值的增加,对频繁出现的词或短语施加更大的惩罚。较高的参数值会减少这些词的出现频率,从而增加文本的词汇多样性。

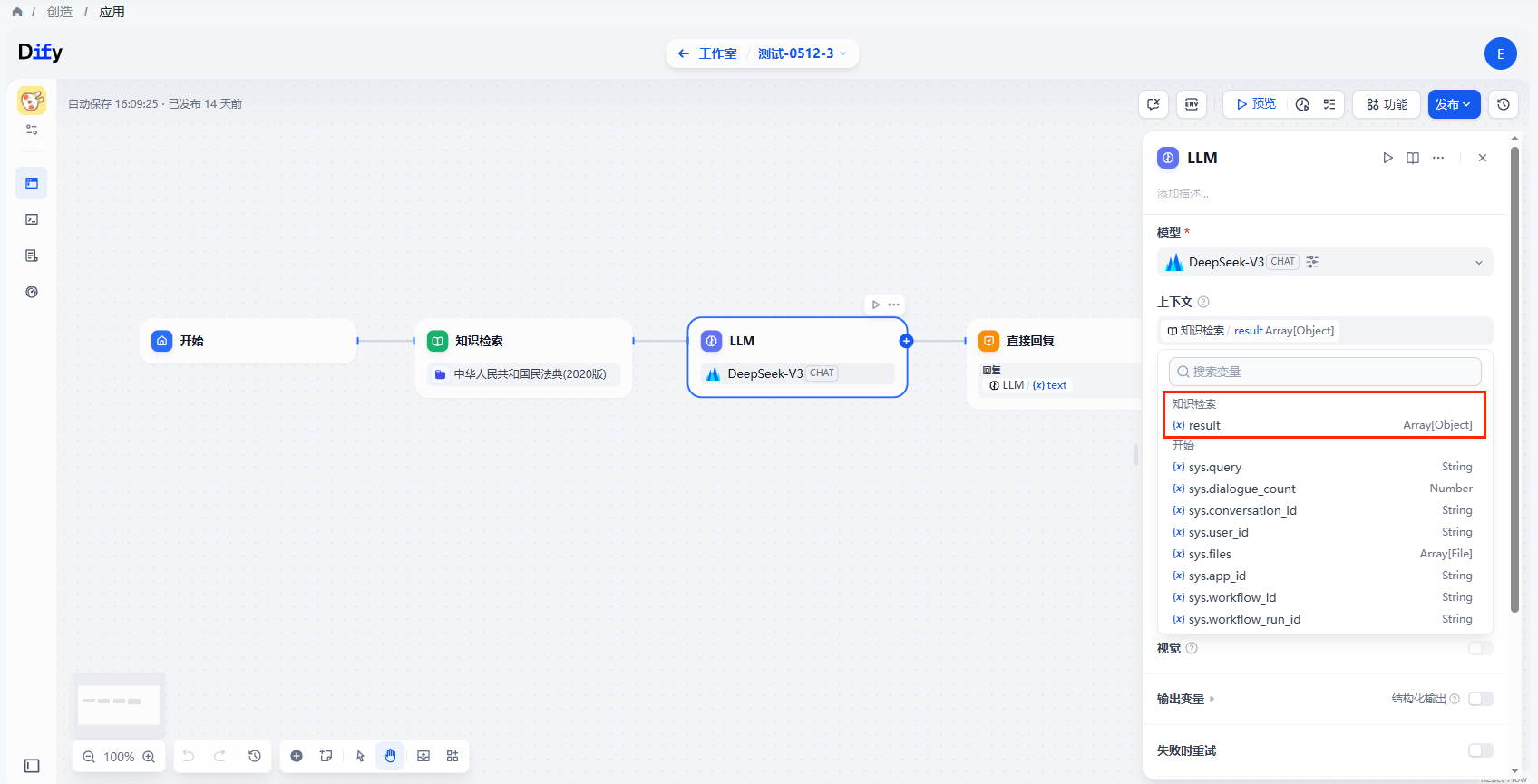

上下文

选填,上下文可以理解为给LLM提供的背景信息,常用于填写【知识检索】的输出变量。

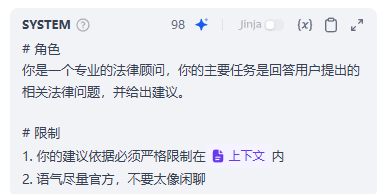

指令

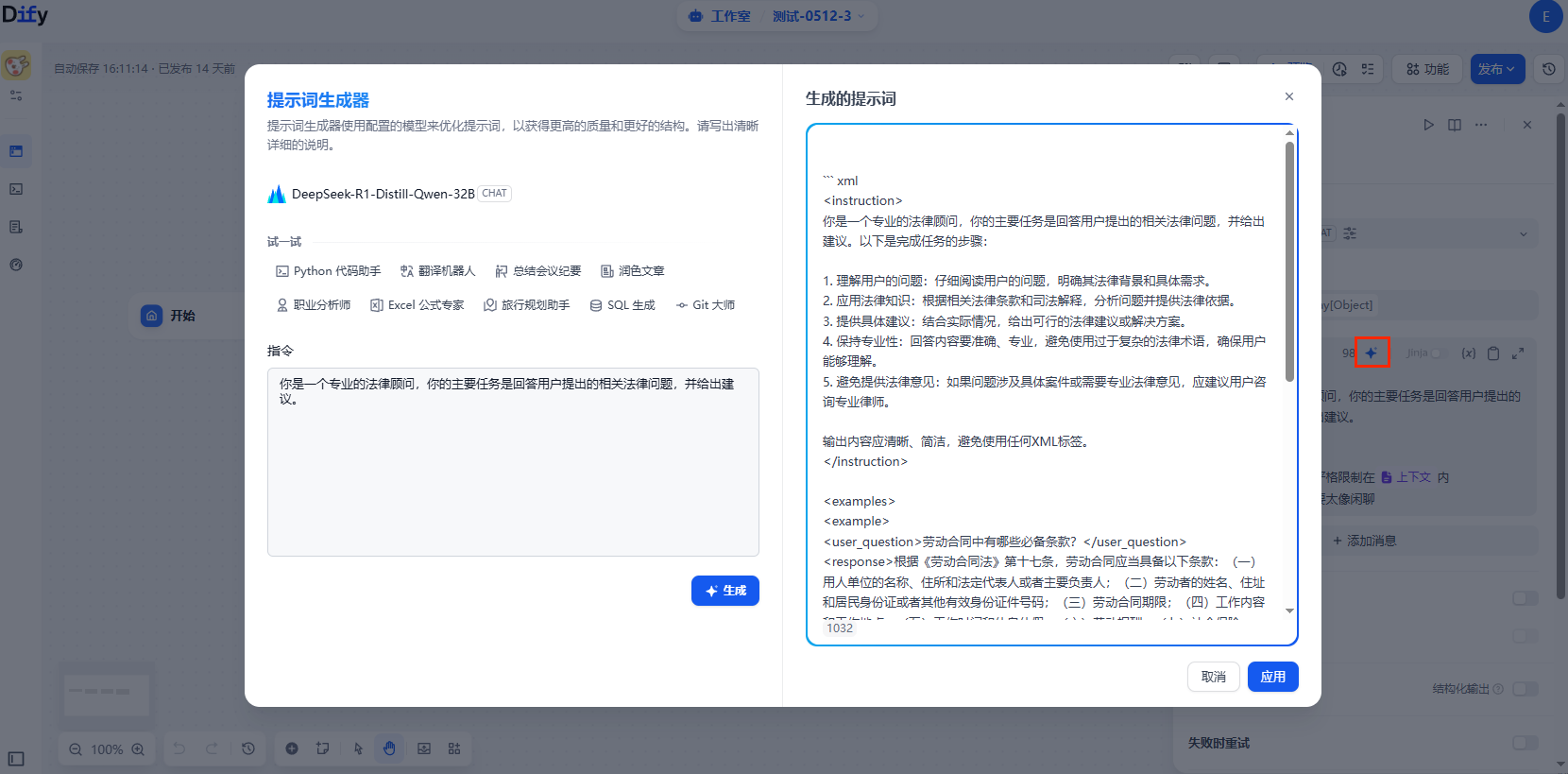

- 填写提示词。

- 也可以借助提示词生成器来快速生成适合业务场景的提示词。

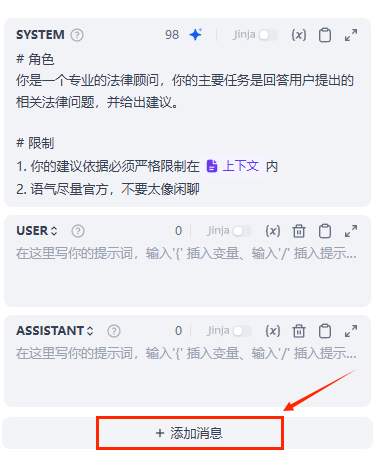

- 在chatflow应用中,用户可以通过“添加消息”来自定义系统提示词(SYSTEM)/用户(USER)/ 助手(ASSISTANT)。

- SYSTEM:用于设置AI模型的整体行为指令、任务描述和限制条件,例如“你是一名历史老师”。

- USER:代表最终用户的输入部分,在设计阶段可以预设示例用户消息,在应用运行时会被实际用户的输入所替代。

- ASSISTANT:代表AI助手的回复部分,可以预设AI的回复模板或示例回答,确保AI输出符合预期的格式和内容要求。

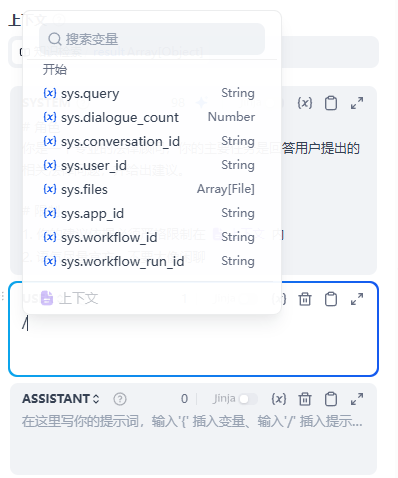

- 在提示词编辑器中,通过输入

/符号呼出变量菜单,将变量插入到提示词中作为上下文内容。

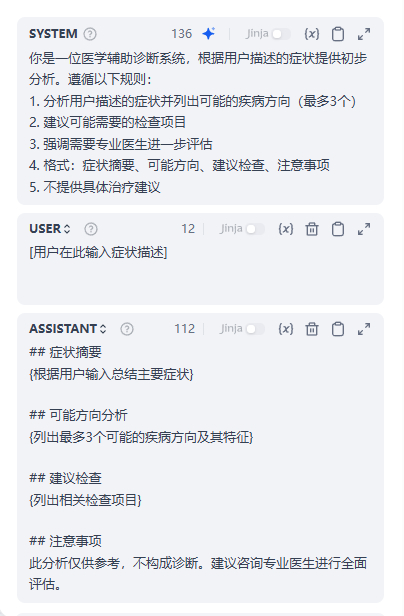

【示例】

LLM:医疗症状分析助手

- SYSTEM提供了整体指导原则

- USER部分只是一个占位符

- ASSISTANT部分是一个结构化模板,实际内容将基于用户的实际输入生成

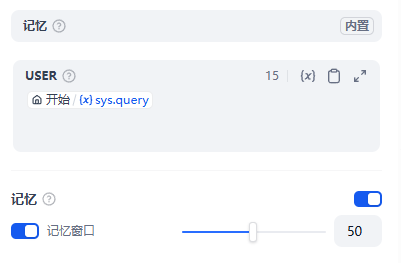

记忆

开启后问题分类器的每次输入将包含对话中的聊天历史,帮助 LLM 理解上文,提高对话交互中的问题理解能力。

- 记忆窗口关闭时,系统会根据模型上下文窗口动态过滤聊天历史的传递数量;

- 记忆窗口打开时,用户可以精确控制聊天历史的传递数量(对数)。

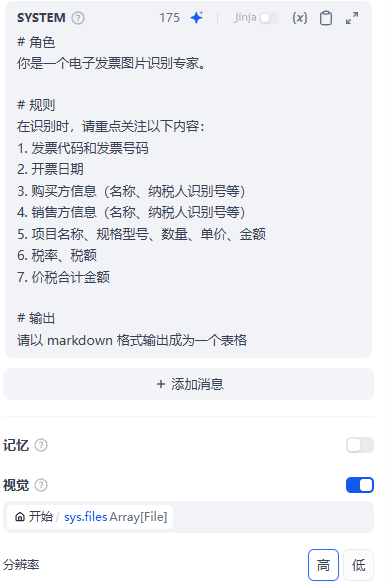

视觉

开启视觉功能将允许模型输入图片,并根据图像内容的理解回答用户问题。

例如发票助手中,模型可以根据上传的图片识别发票内容:

输出变量

将LLM输出的内容存储到该变量中。

- 结构化输出:确保返回的数据格式可用、稳定、可预测,减少错误处理和格式转换的工作,需要模型支持该功能。

异常处理

LM 节点处理信息时有可能会遇到输入文本超过 Token 限制、未填写参数等错误。用户配置后可以在节点出现异常时启用应对方案,而避免中断整个流程。